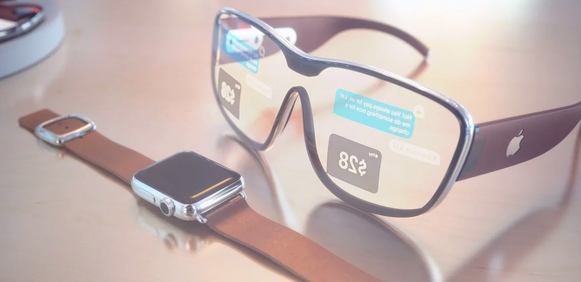

iOS 14悄悄向苹果眼镜迈进了一大步

在2020年世界开发者大会(WWDC)上,苹果宣布了各种操作系统的大量更新,但没有提到任何新硬件。然而,关注WWDC一段时间的人会知道,隐藏在软件公告中的技巧几乎可以揭示设备的下一步发展。

表面上看,都是关于iOS 14的。苹果已经转向ARM和自己的硅片,但在这之下,所有迹象都清楚地表明,你可能会错过苹果眼镜。

苹果在谈论iOS 14或iPadOS时几乎没有提到增强现实(AR),但如果将一些单独的语句放在一起,就会出现更清晰的画面。例子有——AirPods Pro上的空间音频、面向开发者的基于位置的AR工具、应用剪辑、Apple Vision和3D图标的“手势”检测。

有这么多提示和线索,你需要的只是那些智能眼镜,让它们融合在一起。

第一,ARKit4。ARKit是一套面向AR应用开发者的工具,苹果表示,它为-iOS提供了动力,这是全球最大的AR平台。你不要把iOS当成AR平台,因为这项技术还是非常非常新的。然而,其中一个ARKit演示展示了新的“锚点”,以及指向iOS 14和iPadO 14的锚点将如何变化。

这些位置锚使应用程序能够在现实世界的特定位置放置增强现实作品,如路标、雕像甚至游戏角色。这是苹果迈出的第一步。在所有这些地方,戴着苹果眼镜的人都能看到这些虚拟的路标和物体。

除了像口袋妖怪Go这样的游戏,我们还没有真正看到AR在现实世界中迈出一步。宜家只是在你的客厅里移动虚拟家具。苹果在新iPad中使用了LiDAR技术。

在iOS 14和iPadOS 14设备上,ARKit 4可以将苹果地图中的地理坐标与高分辨率地图数据放在一起。ARKit工程师Quinton Petty称之为“视觉定位”,这意味着您将能够相对于周围环境更准确地定位设备,而不仅仅是使用GPS数据。这对AR体验很有意义。苹果还表示,其所有基于位置的ARs都使用运行在您设备上的先进机器学习技术,并且云中没有任何处理,苹果不会向自己或其他任何人发送任何图像。

除了这些“定位主播”,AR主题也有细微的点头,所以智能眼镜是AirPods Pro的空间音频功能。此次更新为您的耳塞带来了3D音效。除非你用AirPods看了很多杜比Atmos的电影,为什么耳塞需要3D音效?

这次更新的真正好处可能是手机自带AR,可以让你对地图上的音频点头,从而为你提供方向或者Apple Glasses眼镜上的AR。

就App Clip而言,这是一个直接的好处,比如无需实际下载完整的应用程序就可以付费,但最终的目的似乎是通过扫描实际对象来帮助您启动ar体验。然后,在苹果的Vision框架下实现了手势控制的“手势”识别,并在ARKit 4中使用了对不同物体和材质进行分类的“场景几何”。

免责声明:本文由用户上传,与本网站立场无关。财经信息仅供读者参考,并不构成投资建议。投资者据此操作,风险自担。 如有侵权请联系删除!

-

昌河北斗星X5试驾,简单几步,开启完美试驾之旅。首先,预约试驾,通过官网或4S店轻松完成;其次,到店后由专...浏览全文>>

-

北汽制造勇士试驾预约,是体验这款硬派越野车型的重要环节。4S店提供便捷的线上预约服务,用户可通过官网或电...浏览全文>>

-

极狐阿尔法T6试驾,开启完美驾驭之旅。外观设计动感时尚,线条流畅,充满未来感。内饰豪华舒适,科技感十足,...浏览全文>>

-

长安欧尚520试驾操作指南:1 启动车辆:插入智能钥匙,踩下刹车,按下启动按钮。2 选择驾驶模式:通过中...浏览全文>>

-

试驾五菱凯捷可通过以下几种途径:1 4S店试驾:前往当地五菱汽车授权经销商,直接预约试驾服务,专业销售顾...浏览全文>>

-

MINI试驾线上+线下操作指南线上预约:访问MINI官网或官方APP,选择“试驾预约”,填写个人信息、车型偏好及时...浏览全文>>

-

力帆预约试驾,一键搞定,开启豪华驾驶之旅。只需简单几步,即可在线预约心仪车型的试驾体验,省时又便捷。无...浏览全文>>

-

SONGSAN MOTORS试驾预约,开启非凡驾驶之旅!我们为您精心准备了多款高性能车型,无论您是追求速度的激情玩家...浏览全文>>

-

欧拉试驾预约,轻松几步,畅享豪华驾乘。只需三步,即可开启您的专属体验:第一步,访问欧拉官网或官方APP,点...浏览全文>>

-

MINI试驾,线上+线下操作指南线上预约:访问MINI官网或官方APP,选择“试驾预约”,填写个人信息、车型偏好及...浏览全文>>

- 北汽制造勇士试驾预约,4S店的贴心服务与流程

- MINI试驾,线上+线下操作指南

- 零跑汽车试驾,如何在4S店快速预约?

- 试驾MG4 EV全攻略

- 长安欧尚520试驾操作指南

- IPHONE 17 系列或将提供高达 35W 的有线充电

- OPPO FIND N5 推出迄今为止最薄的可折叠智能手机

- IPHONE 上的 CHROME 和 GOOGLE APPS 正在使用 CIRCLE 进行搜索

- OPPO 推出 WATCH X2

- NOTHING PHONE在 3 月 4 日发布前的完整详细信息

- Nintendo Switch 2 渲染图显示其支架经过重新设计,拥有新按钮,但缺少一个插槽Nintendo Switch 2 渲染图显示其支架经过重新设计 拥有新按钮

- 据传卡西欧 CRW-001 新款金色戒指手表即将上市

- FPGA 游戏机的灵感来自 PS One 起价 149 美元

- 伊利诺伊州住房市场在利率上升的情况下保持稳定

- Realme 14x 5G 搭载联发科 Dimensity 6300 SoC

- 三星 Galaxy S25 Ultra 渲染图泄露 显示圆角设计

- 预计三星 Galaxy S25 Ultra 的边框将比其前代产品更薄

- 三星 Galaxy Unpacked 2025 或将于 1 月 22 日举行

- Rivian 通过假日更新推出 Google Cast 支持

- 圣诞老人的房子在房地产网站上挂牌出售 估价 120 万美元